ТГУ и «Наносемантика» научат студентов

готовить «топливо» для ИИ

готовить «топливо» для ИИ

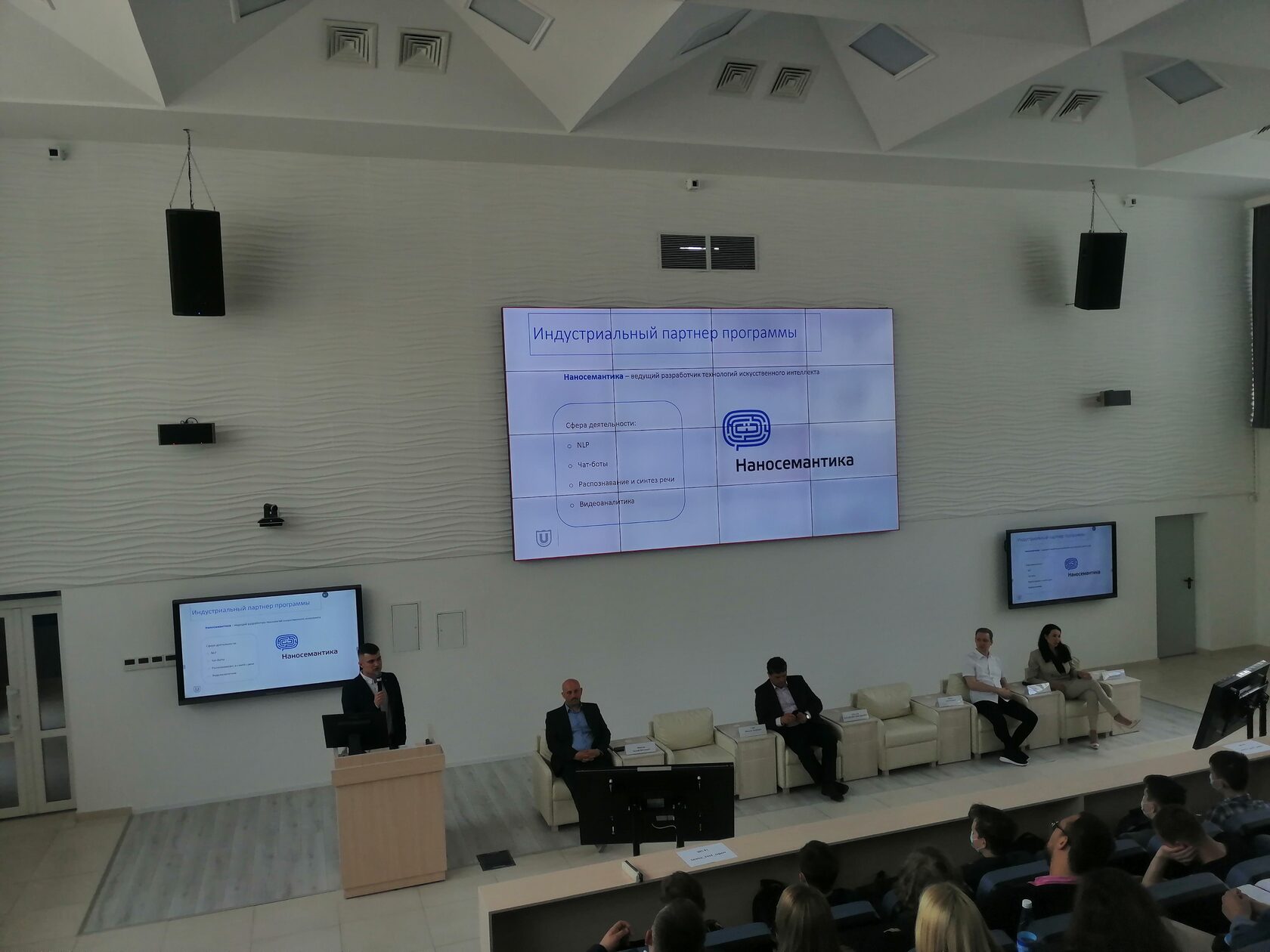

ТГУ и компания «Наносемантика» презентовали на научном семинаре по работе с большими данными "Большие данные. Большие вызовы" курс по контент-аналитике для студентов. Студентов научат готовить «топливо» для машинного обучения – то есть данные, на основе которых ИИ выявляет полезные закономерности и подбирает «математическую формулу» для их анализа.

За разработку программы отвечает Центр прикладного анализа больших данных ТГУ. Компания «Наносемантика» предоставляет доступ к платформе по разметке данных NlabMarker, а также участвует в проработке учебных модулей. Лучших студентов пригласят на стажировку в компанию. Новый курс будет доступен всем желающим студентам ТГУ.

– Основная проблема любого разработчика искусственного интеллекта – где добыть такой датасет – массив обучающих данных – который будет и качественным, и большим, и релевантным поставленной задаче. Любой достаточно большой датасет требует огромного количества ручного труда: иногда это труд людей без специализации, а иногда – труд врачей, юристов или лингвистов. В любом случае, участник этого процесса – контент-аналитик, разметчик, асессор – должен понимать критерии качества, способы организации работы над разметкой, а также уметь работать в различных инструментах для сбора, разметки и аналитики данных, – объясняет Станислав Ашманов, глава компании «Наносемантика».

Сейчас рынок нейросетей испытывает большую нехватку контент-аналитиков, специалистов, которые умеют собирать, обрабатывать, классифицировать и анализировать текстовый контент для решения задач на основе ИИ в разных отраслях. Студенты ТГУ получат возможность получить эту специальность как дополнительную к основной, и уже в студенчестве найти работу.

– Мы и сами столкнулись с нехваткой хорошо подготовленных контент-аналитиков, когда выполняли большой проект по анализу мнений и настроений российского студенчества в рамках заказа Минобрнауки в прошлом году, – рассказывает Вячеслав Гойко, директор Центра прикладного анализа больших данных ТГУ. – Теперь мы готовы обучать студентов и трудоустраивать их в свои проекты, а также в проекты наших партнеров по Консорциуму исследователей больших данных в других вузах страны.

Благодаря программе, разработчики планируют обеспечить рынок ИИ достаточным количеством специалистов по датасетам, без которых невозможна разработка алгоритмов продвинутой автоматизации.

Михаил Мягков, председатель правления ассоциации «Университетский консорциум исследователей больших данных», заведующий лабораторией экспериментальных методов в общественных и когнитивных науках ТГУ: «Создание на базе ТГУ и Университетского консорциума исследователей больших данный программы по подготовке контент-аналитиков — это свидетельство того, насколько в новом быстро меняющемся мире цифровых технологий есть необходимость в постоянном поиске инновационных подходов к созданию новых образовательных программ. Действительно, любой прикладной анализ данных, да и не прикладной тоже начинается с анализа сырых данных, которые как правило представляют собой огромное количество замусоренного массива цифровой информации, которую нужно сортировать, которую нужно обрабатывать и здесь не обойтись без человеческих глаз, без естественного интеллекта. И вот для того, чтобы эти данные были приготовлены, для того чтобы они были структурированы, нам как раз необходима огромная армия, таких знаете каменщиков на стройке искусственного интеллекта и вот, собственно, ТГУ и Консорциум выступили с инициативой о создании централизованной подготовке большого количества специалистов по контент аналитике. Мы будем создавать механизмы верификации работы данных, будем выдавать сертификаты разных степеней. Эта профессия она со временем на самом деле станет одной из таких, как минимум очень популярный студенческих подработок, но мне кажется в будущем она вырастет во что-то гораздо большее.»

Ссылка на источник: http://www.tsu.ru/news/tgu-i-nanosemantika-nauchat-studentov-gotovit-topl/

За разработку программы отвечает Центр прикладного анализа больших данных ТГУ. Компания «Наносемантика» предоставляет доступ к платформе по разметке данных NlabMarker, а также участвует в проработке учебных модулей. Лучших студентов пригласят на стажировку в компанию. Новый курс будет доступен всем желающим студентам ТГУ.

– Основная проблема любого разработчика искусственного интеллекта – где добыть такой датасет – массив обучающих данных – который будет и качественным, и большим, и релевантным поставленной задаче. Любой достаточно большой датасет требует огромного количества ручного труда: иногда это труд людей без специализации, а иногда – труд врачей, юристов или лингвистов. В любом случае, участник этого процесса – контент-аналитик, разметчик, асессор – должен понимать критерии качества, способы организации работы над разметкой, а также уметь работать в различных инструментах для сбора, разметки и аналитики данных, – объясняет Станислав Ашманов, глава компании «Наносемантика».

Сейчас рынок нейросетей испытывает большую нехватку контент-аналитиков, специалистов, которые умеют собирать, обрабатывать, классифицировать и анализировать текстовый контент для решения задач на основе ИИ в разных отраслях. Студенты ТГУ получат возможность получить эту специальность как дополнительную к основной, и уже в студенчестве найти работу.

– Мы и сами столкнулись с нехваткой хорошо подготовленных контент-аналитиков, когда выполняли большой проект по анализу мнений и настроений российского студенчества в рамках заказа Минобрнауки в прошлом году, – рассказывает Вячеслав Гойко, директор Центра прикладного анализа больших данных ТГУ. – Теперь мы готовы обучать студентов и трудоустраивать их в свои проекты, а также в проекты наших партнеров по Консорциуму исследователей больших данных в других вузах страны.

Благодаря программе, разработчики планируют обеспечить рынок ИИ достаточным количеством специалистов по датасетам, без которых невозможна разработка алгоритмов продвинутой автоматизации.

Михаил Мягков, председатель правления ассоциации «Университетский консорциум исследователей больших данных», заведующий лабораторией экспериментальных методов в общественных и когнитивных науках ТГУ: «Создание на базе ТГУ и Университетского консорциума исследователей больших данный программы по подготовке контент-аналитиков — это свидетельство того, насколько в новом быстро меняющемся мире цифровых технологий есть необходимость в постоянном поиске инновационных подходов к созданию новых образовательных программ. Действительно, любой прикладной анализ данных, да и не прикладной тоже начинается с анализа сырых данных, которые как правило представляют собой огромное количество замусоренного массива цифровой информации, которую нужно сортировать, которую нужно обрабатывать и здесь не обойтись без человеческих глаз, без естественного интеллекта. И вот для того, чтобы эти данные были приготовлены, для того чтобы они были структурированы, нам как раз необходима огромная армия, таких знаете каменщиков на стройке искусственного интеллекта и вот, собственно, ТГУ и Консорциум выступили с инициативой о создании централизованной подготовке большого количества специалистов по контент аналитике. Мы будем создавать механизмы верификации работы данных, будем выдавать сертификаты разных степеней. Эта профессия она со временем на самом деле станет одной из таких, как минимум очень популярный студенческих подработок, но мне кажется в будущем она вырастет во что-то гораздо большее.»

Ссылка на источник: http://www.tsu.ru/news/tgu-i-nanosemantika-nauchat-studentov-gotovit-topl/